Notfall

Vorsorge ist der erste Schritt sich auf einen Notfall vorzubereiten

- Hauptdokument

- Hauptdokument MS Office / OpenOffice / ERP / 3CX

- Audit Office / ERP / 3CX

- Buissnes Impact Analyse

- Leitlinie Office / ERP / 3CX

- Notfallhandbuch

- Notfallvorsorgekonzept Office

- Risikoanalyse

- Schulung und Sensibilisierung

- Strategieentwicklung

- Übung und Test Office / ERP / 3CX

- Leitfaden Office / ERP / 3CX

Microsoft Ausfall 25 Januar 2023

Microsoft hat Informationen zu den Ursachen für den Ausfall seiner cloud-basierten Dienste veröffentlicht. Wegen eines Ausfalls im Bereich der Azure Cloud von Microsoft konnte am Mittwochmorgen, den 25. Januar. Zwischen 08:05 Uhr und 13:43 Uhr unserer Zeit stellten Kunden am Mittwoch Konnektivitätsprobleme fest, die sich in hohen Latenzen, Paketverlusten und Timeouts beim Zugriff auf Azure-Cloud-Ressourcen niederschlugen. Eine Vielzahl von Nutzenden nicht auf Applikationen und Dienste zugreifen, die über diese Plattform gehostet werden. Darunter unter anderem das weit verbreitete Kollaborationswerkzeug Teams, aber auch andere Microsoft 365 Anwendungen wie Outlook, Word, Excel funktionierten in deren Cloud-basierenden Varianten nicht.

Ein Grund mehr aus der Claud zu bleiben.

Einmal Cloud und wieder zurück!

Die Faszination hält an, auch von einer Umkehrung des Trends kann nicht die Rede sein, aber ein wachsendes Selbstbewusstsein der Kunden, manch negative Erfahrung dort und neue Technik hier, aber auch der Trend zu IT- und Datenhoheit, stoppen die Reise recht vieler Unternehmen mit einem One-Way-Ticket.

Nachdem Analysten den vermeintlichen Tugenden der Cloud-Migration Jahr für Jahr bis zum Überdruss das Loblied sangen, stellen viele Organisationen nach und nach fest, dass ihnen mit dem eigenen Rechenzentrum doch gar nicht so schlecht gedient war. Zum einen hatten sie hier die Kosten unter Kontrolle – anders als in der Cloud. Zum anderen war die Performance besser – und nebenbei fast unfehlbar, verglichen mit der Cloud. Was ihr bei der Cloud also bekommt, sind nicht die CPU Ressourcen, sondern priorisierte Prozesse, dazu noch versteckte Kosten wie etwa Laufzeit, Segmentierung und Routing um mal ein paar zu nennen.

Das eigene Rechenzentrum ist skalierbar und lässt sich unterschiedlichem Rechenbedarf in einer von Services geprägten Inhouse-Umgebung anpassen. Die Datenverarbeitung im lokalen Netz hat zwei Vorteile: Alle Daten bleiben in einem kontrollierbaren Raum und die IT-Ressourcen werden optimal eingesetzt und wir müssen uns nicht fragen, wer die Datenhoheit hat.

Aufgrund der COVID-19-Pandemie, welchen Crash bringt uns die Zukunft? Wirtschaftskrieg, sogar ein Handelsembargo? Beschädigte Seekabel aus anderen Ländern? Abgestürzte Satelliten? Auf jeden Fall täten Europa und europäische Unternehmen gut daran, sich auf Alternativen zu konzentrieren, um ihre Abhängigkeit von US-Konzernen zu verringern, wie sagte Trump: America First!

Ist die Cloud eine bessere Alternative?

Im März 2021 ist eines von vier Rechenzentren des großen Cloudanbieters OVH in Straßburg abgebrannt. Dabei wurden vier Serverhallen komplett zerstört. Einige Kunden des Unternehmens hatten keine Backup-Dienste gebucht und auch keine Recovery-Pläne erarbeitet. Diese Unternehmen haben durch den Brand viele Daten verloren und riesige Kosten und Verluste zu verzeichnen.

Die Betreiber von Rechenzentren haben weiterhin mit Stromausfallproblemen zu kämpfen. Bei den öffentlich gemeldeten Ausfällen kommt es immer häufiger zu längeren Ausfallzeiten. Was auch mit der Komplexität der Netzwerke zu tun hat, Vodafone und Telekom z. B. damit wäre der Vorteil bei einer internen Lösung zu finden, gerade bei Firmen, die über mehrere Standorte verteilt sind, spricht es dafür Standortserver einzurichten. Abteilungen können weiter arbeiten und sind nicht voneinander abhängig. Das Backup erfolgt in der Zentrale, raucht ein Abteilungsserver ab, setzt der Mitarbeiter den Ersatzserver auf, fährt rüber und tauscht mal eben aus und schon kann die Abteilung weiter arbeiten.

Die unbegrenzte Sichtbarkeit der eigenen IT On-premise schuf zudem auch noch Planungssicherheit. Und in Sachen Cybersicherheit hat das eigene Rechenzentrum ohnehin schon seit jeher die Nase vorn. Die Cloud-Anbieter sind Auftragsverarbeiter, die ihre Dienste gegen Geld anbietet. Er erhält aber nicht nur dein Geld und deine Dokumente, sondern auch deine Nutzerdaten, Diagnosedaten, Trackingdaten etc. - und da fängt das datenschutzrechtliche Problem an, denn du hast kaum eine Kontrolle darüber, was der Dienstleister mit deinen Daten macht, daran ändert sich auch nicht viel, wenn du mit dem Dienstleister (wie vorgeschrieben und doch nur selten umgesetzt) einen Vertrag über die Auftragsdatenverarbeitung abschließt.

Im EU-Raum oder in Deutschland mag die Speicherung von Dokumenten auf fremden Servern rechtlich noch relativ gesichert sein, aber was, wenn der Anbieter seinen Service im US-amerikanischen Raum (und nicht nur dort) anbietet, wo man sich um Datenschutz nicht so sehr viele Grenzen setzt? Also geht es jetzt doch aus den Wolken zurück in die eigenen vier Wände!

Ich habe mir das auch ein halbes Jahr bei einer der großen Firmen anschauen können und habe mich wieder auf das Altbewährte besonnen.

Ich bin aber nicht abgeneigt geben über Innovationen wie Docker, Grafana oder Proxmox sowie Warenwirtschaftssystem Systeme ERP von HYREKA es gibt immer noch kleine Unternehmen, die einen Service anbieten, die Microsoft und Co nicht leisten können.

Hinzu kommen die Kosten für Schulungen in den Cloud-Anwendungen, Zeit und Arbeitskraft, die dort erst einmal investiert werden könnten, auch gleich in die laufende IT fließen. Hier sollten Alternativen zu Office 365 gesucht werden wie Group Office und sich somit noch eine Menge Geld sparen lässt.

Cloud Ansätze

Muss ich eine Cloud haben oder reicht doch ein Network Attached Storage?

Die Cloud ist Dreh- und Angelpunkt der IT geworden. Reflexartig verschieben IT-Verantwortliche mittlerweile Daten aller Art dorthin. Aber die Cloud kann nicht alles; Network Attached Storage hat immer noch viele Vorteile.

Wie teuer ist Cloud und was bekomme ich? Also: Es gibt in der Regel keine Vorabinvestitionen für die Nutzung einer Public Cloud, was gut ist, aber die Betriebskosten wachsen mit den Speicheranforderungen. Ein NAS-Gerät hingegen kostet viel bei der Anschaffung, die laufenden Kosten dagegen sind im Vergleich zum Cloud Storage gering. Docker und VM können diese auch und die CPU resource ist hier wesentlich höher als in der Cloud.

5 Euro pro Terabyte (TB) und Monat zu Buche. Die Speicher zeichnen sich bekanntlich dadurch aus, dass die Zugriffe langsam erfolgen – was schon mal ein Hindernis für so manches Unternehmen darstellen kann. Benötigt man schnellere Zugriffe, steigt der Preis schnell auf über 25 Euro pro TB und Monat an. 12 Monate mal 5 € sind 60 € pro Jahr und bei einer SSD 25 € mal 12 Monate sind 300 € pro Jahr.

Im Vergleich dazu bekommen KMU’s und Privatanwender Synology DS419 Slim eine typische NAS-Appliance inklusive Chassis und vier 5TB-Laufwerken (Gesamtkapazität also 20 TB) zu einem Preis von knapp über 950 € Euro. Im Endeffekt fallen also 45 Euro pro TB an. Da es sich um eine einmalige Zahlung handelt, dauert es nur wenige Monate, bis das NAS günstiger als die Cloud wird – vorausgesetzt, die volle Kapazität wird genutzt. Okay, Strom, Kühlung, Wartung und andere laufende Kosten fallen auch noch an, aber im Prinzip wird klar: NAS kann langfristig günstiger kommen als die Cloud.

Flexibilität vs. Kontrolle

Wie gesehen, kann NAS günstiger kommen, macht aber unfrei und weniger flexibel – ein NAS-System haben Anwender schließlich für lange Zeit am Hals, die Angebote der Public Cloud können mehr oder weniger schnell gewechselt werden. Internetanschluss hat jedes Haus, mehr oder weniger schnell. Aber wenn es zum Ausfall kommt geht nichts mehr.

NAS-basierte Ansätze bieten dafür in der Regel eine größere Kontrolle als Cloud-Archive, einfach, weil sie lokal im hauseigenen Serverraum oder Rechenzentrum stehen. Publik-Cloud-basiertes Storage offeriert jedoch in der Regel ebenfalls eine akzeptable Zugriffsflexibilität sowie ein hohes Maß an Kontrolle, auch wenn keiner weiß, wo auf der Welt die Daten liegen, das entbindet aber nicht diese Daten auch zu sichern, auch über eine Verschlüsselung muss nachgedacht werden.

Hochverfügbarkeit

Hochverfügbarkeit (englisch high availability, HA) bezeichnet die Fähigkeit eines Systems, trotz Ausfalls einer seiner Komponenten mit einer hohen Wahrscheinlichkeit (oft 99,99 % oder besser) den Betrieb zu gewährleisten. Das Gegebensein von Robustheit gegen Benutzungsfehler(vormals als „Fehlertoleranz“ bezeichnet) gilt als Grundvoraussetzung für die Bereitstellung bzw. Verwirklichung von „Hochverfügbarkeit“. Die essenziellen Funktionen eines Systems, das dem Kriterium der „Hochverfügbarkeit“ genügen soll, dürfen nur innerhalb festgelegter Zeiten oder allenfalls minimal zur Hauptbetriebszeit unterbrochen werden.

Voraussetzungen für hohe Verfügbarkeiten

Generell streben HA-Systeme danach, sogenannte Single-Point-of-Failure-Risiken (SPOF) zu eliminieren (ein SPOF ist eine einzelne Komponente, deren Versagen zum Ausfall des gesamten Systems führt).

Ein Hersteller eines hochverfügbaren Systems muss dieses mit folgenden Merkmalen ausstatten: Redundanz kritischer Systemkomponenten fehlertolerantes und robustes Verhalten des Gesamtsystems

Typische Beispiele für Komponenten, die zum Erreichen einer erhöhten Fehlertoleranz eingesetzt werden, sind unterbrechungsfreie Stromversorgungen (USV; engl. uninterruptible power supply, UPS), mehrfache Netzteile, ECC-Speicher oder der Einsatz von RAID-Systemen. Weiter kommen Techniken zur Serverspiegelung oder auch redundante Cluster zum Einsatz.

Je höher die geforderte Verfügbarkeit ist, desto mehr Aufwand muss der Betreiber investieren in:

schnell erreichbares Fachpersonal, Ersatzteilverfügbarkeit, vorbeugende Wartung, qualifiziertes Fehlermeldung und schnelles Kommunikationssystem

Hoch spezialisierte Systeme mit höchsten Verfügbarkeiten sind beispielsweise

die Continuum Serien von Stratusdie Integrity NonStop Serien bei HP, die aus der Übernahme von Tandem (1997) sowie der Digital Equipment Corporation (1998) über Compaqhervorgegangen sindgenerell Großrechner, z. B. jene dem System z-Serie der Firma IBMFernsprechvermittlungsstellen.

Verfügbarkeit

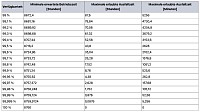

Für ein System, das 24 Stunden am Tag, an 365 Jahrestagen (24 × 365) zur Verfügung steht (8760 Stunden), bedeutet dies: siehe Bild

Hier steht keine Restzeit mehr zur Verfügung. Die Wartung muss daher in der erlaubten Ausfallzeit erfolgen.

Zur Optimierung der Verfügbarkeit kann man unter anderem den Verfügbarkeitsverbund einsetzen.

Systeme, die mit einer hohen Verfügbarkeit (99,99 % oder besser) laufen müssen, bezeichnet man als hochverfügbare Systeme.

Kennzahlen der Verfügbarkeit sind

maximale Dauer eines einzelnen Ausfalls (Verfügbarkeit: Ausfallzeit im Jahresdurchschnitt, auch Verfügbarkeitsklasse), Zuverlässigkeit (Fähigkeit, über einen gegebenen Zeitraum hinweg unter bestimmten Bedingungen korrekt zu arbeiten), Fehlersicherer Betrieb (Robustheit gegen Fehlbedienung, Sabotage und höhere Gewalt), System- und Datenintegrität, Wartbarkeit (verallgemeinernd: Benutzbarkeit überhaupt), Reaktionszeit (wie lange dauert es, bis das System eine spezielle Aktion ausgeführt hat),Mean Time to Repair (MTTR, mittlere Dauer der Wiederherstellung nach einem Ausfall),Mean Time between Failure (MTBF, mittlere Betriebszeit zwischen zwei auftretenden Fehlern ohne Reparaturzeit),Mean Time to Failure (MTTF, siehe MTBF, wird jedoch bei Systemen/Komponenten verwendet, die nicht repariert, sondern ausgetauscht werden).

Besteht ein System aus mehreren aufeinander aufbauenden Teilsystemen, ergibt sich die gesamte Netto-Verfügbarkeit aus der Multiplikation der Verfügbarkeitswerte der einzelnen Teilsysteme (Stochastisch unabhängige Ereignisse).

Beispiel:

Eine Anwendung in einem Datacenter hat eine Verfügbarkeit von 99,5 % und die zugrundeliegende Leitung eine Verfügbarkeit von 98,5 % dann ergibt sich eine Gesamtverfügbarkeit von 98.

Quelle Wikipedia

Notfall, was muss beachtet werden!

IT Ausfallanalyse und warum müssen wir den Ausfall analysieren? Geschäftstätigkeit im Unternehmen können, auch wenn nur teilweise Bereiche ausfallen, den täglichen Ablauf stark in Mitleidenschaft gezogen werden, die sich in Ausfallzeiten berechnen lassen. Der Notfallplan lässt Rückschlüsse ziehen, wie teurer es der Firma wird. Ob eine Stunde, einen Tag, eine Woche in Mitleidenschaft ziehen kann und mit wie viel Aufwand sich diese Kosten hätten minimiert ließen. Unter anderem eine Abteilung, die den Versand, Garantie und Reparaturen macht, setzt sich aus 1 Abteilungsleiter, 4 Packer, 3 Elektroniker, 2 Sachbearbeiterinnen zusammen. Der Switch in der Abteilung ist nun ausgefallen, nichts geht mehr für 2 Tage, bis der neue Switch vor Ort ist, dann berechnet sich die Kosten wie folgt, Stundenlohn mal Zeit mal Personen plus die nicht ausgelieferte Ware macht ~ 3200 € an Personalkosten, für das Geld kann ich mir auch einen Switch in die Ecke legen bzw. die IT hat in ihrer Laborumgebung genau den gleichen Typ wie im Unternehmen überall eingesetzt wird.

Was muss wann wie gemacht werden, wenn es zu einem Ausfall kommt, diese Frage und das Durchspielen der möglichen Ausfälle sind ein erster Schritt diese Sicherheitsanalyse zu erstellen.

Erst zu handeln, wenn es passiert ist, lassen die Kosten in die Höhe schnellen.

Überstürztes Handeln vermeiden, zuständiges Personal aktivieren, dokumentieren, Daten wieder herstellen, testen auf Funktionen und System wieder aktiv und produktiv in Bereitschaft zu versetzen sollte nicht erst gemacht werden, wenn es wirklich eintrifft.

Die IT sollte viel mehr auch sich die Zeit nehmen den Ernstfall in der Praxis zu testen. Wann sollen wir das denn machen?

Wann haben wir Betriebsferien oder über welche Feiertage sind unsere Kollegen nicht da, ist hier die einzig richtige Frage.

Zu Beginn sollten wir schauen, wo Bedarf, Pflege und mögliche Verbesserung zweckmäßig sind.

Vorgehensweise

Zu Beginn sollten wir schauen, wo Bedarf, Pflege und mögliche Verbesserung zweckmäßig sind. Bedarf ermitteln, Anforderungen festlegen, Bedienungsanleitung schreiben, Ablaufplan erstellen, Testlauf durchführen, Ergebnisse des Testlaufs auswerten und Verbesserungen einpflegen

Somit bist Du schon mal vorbereitet, wenn etwas passiert.

Befallener VMWare Host

Ein System wurde befallen, aber ihr müsst unbedingt noch mal an die Daten kommen, ohne das andere Systeme davon befallen werden können.

Das befallene System in eine DMZ ohne Netzwerk Adapter verschieben, die Geräte könnt ihr in der Hardwarekonfiguration der VM entfernen.

In der normalen Umgebung installiert ihr eine neu VM mit allen Aktualisierungen und Virenschutzprogramm.

Herunterfahren und anschließend in die DMZ verschieben, nun die Festplatten des befallenen Systems an die eben verschobene VM einhängen und starten.

Jetzt können die Festplatten mit dem Virenscanner durchforstet werden.

Nach dem alle Viren entfernt wurden, die VM herunterfahren und die eben zugeführten Festplatten wieder aushängen, aber nicht löschen!

Jetzt könnt ihr das befallene System wieder starten, da keine Netzwerkkarten vorhanden, könnt ihr nur Daten über einen Export in eine separaten VM Festplatte durchführen.

Diese anschließend wieder in den Virenscanner einhängen und scannen.

Daten können inzwischen importiert werden, so habt ihr den erneuten Befall eurer System vorgebeugt.

Garantieren kann man aber nicht dafür, dieses sollte euch mal wesentliche Schritte erläutern, um das Risiko so gering wie möglich zu halten.